Un modèle informatique capable de localiser les sons comme le cerveau humain

Recherche

Les neuroscientifiques du Massachusetts Institute of Technology ont mis au point un modèle informatique (réseau neuronal profond) capable de déterminer la localisation des sons dans l'espace. Cette capacité est stratégique pour la conception des aides auditives.

Le modèle informatique mis au point par les scientifiques du MIT est parvenu à localiser avec précision l’origine du son, dans des conditions réalistes avec du bruit et de la réverbération. Ce modèle pourrait permettre aux aides auditives de sélectionner les sons et de les restituer au porteur plus naturellement.

Dans les expériences simulées, le modèle présentait de nombreuses caractéristiques de l’audition spatiale humaine : sensibilité aux fréquences et aux différences de temps et de niveau entre les deux oreilles. Mais lorsqu’ils ont été entraînés dans des environnements non naturels, sans réverbération, sans bruit ni sons naturels, ces caractéristiques de performance se sont écartées de celles des humains. Les résultats montrent comment l’audition biologique est adaptée aux défis des environnements du monde réel et illustrent comment les réseaux neuronaux artificiels peuvent intégrer les contraintes du monde réel qui façonnent la perception. « Nous disposons désormais d’un modèle capable de localiser les sons dans le monde réel », explique Josh McDermott, professeur associé de sciences du cerveau et de sciences cognitives et membre du McGovern Institute for Brain Research du MIT.

Les réseaux neuronaux convolutifs

Pour développer ce modèle de localisation sophistiqué, l’équipe du MIT s’est tournée vers les réseaux neuronaux convolutifs. Ce type de modélisation informatique a été largement utilisé pour modéliser le système visuel humain et, plus récemment, McDermott et d’autres scientifiques ont commencé à l’appliquer à l’audition. Les réseaux neuronaux convolutifs peuvent être conçus avec de nombreuses architectures différentes. Pour les aider à trouver ceux qui fonctionneraient le mieux pour la localisation, l’équipe du MIT a utilisé un superordinateur qui leur a permis d’entraîner et de tester environ 1 500 modèles différents.

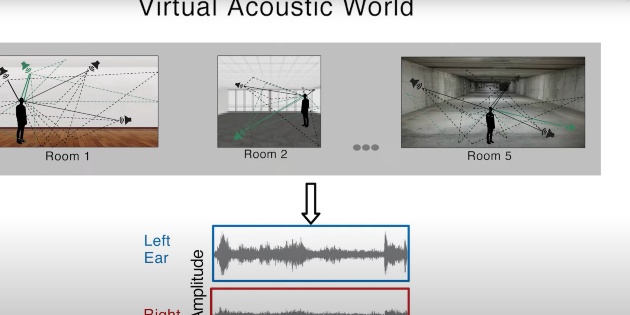

Cette recherche a permis d’en identifier dix qui semblaient les mieux adaptés à la localisation, que les chercheurs ont ensuite entraînés et utilisés pour toutes leurs études ultérieures. Pour entraîner les modèles, les chercheurs ont créé un monde virtuel dans lequel ils peuvent contrôler la taille de la pièce et les propriétés de réflexion des murs de la pièce. Tous les sons transmis aux modèles provenaient de l’une de ces pièces virtuelles. L’ensemble de plus de 400 sons d’entraînement comprenait des voix humaines, des sons d’animaux, des sons de machines tels que des moteurs de voiture et des sons naturels tels que le tonnerre. Les chercheurs se sont également assurés que le modèle partait des mêmes informations que celles fournies par les oreilles humaines. L’oreille externe, ou pavillon, comporte de nombreux plis qui réfléchissent le son, modifiant les fréquences qui entrent dans l’oreille, et ces réflexions varient en fonction de la provenance du son. Les chercheurs ont simulé cet effet en faisant passer chaque son par une fonction mathématique spécialisée avant de l’intégrer au modèle informatique.

Des résultats très similaires à ceux des humains

Après avoir entraîné les modèles, les chercheurs les ont testés dans un environnement réel. Ils ont placé un mannequin avec des microphones dans les oreilles dans une pièce réelle et ont diffusé des sons provenant de différentes directions, puis ont transmis ces enregistrements aux modèles. Les modèles ont obtenu des résultats très similaires à ceux des humains lorsqu’on leur a demandé de localiser ces sons. Les chercheurs ont ensuite soumis les modèles à une série de tests que les scientifiques ont utilisés par le passé pour étudier les capacités de localisation des humains. Outre l’analyse de la différence de temps d’arrivée à l’oreille droite et à l’oreille gauche, le cerveau humain fonde également ses jugements de localisation sur les différences d’intensité du son qui parvient à chaque oreille. Des études antérieures ont montré que le succès de ces deux stratégies varie en fonction de la fréquence du son. L’équipe du MIT a constaté que les modèles présentaient le même type de sensibilité à la fréquence. Les chercheurs ont également montré que lorsqu’ils rendaient les tâches de localisation plus difficiles, en ajoutant plusieurs sources sonores jouées en même temps, les performances des modèles informatiques diminuaient d’une manière qui imitait étroitement les schémas d’échec humains dans les mêmes circonstances.

Les chercheurs appliquent maintenant ce type de modélisation à d’autres aspects de l’audition, tels que la perception de la hauteur et la reconnaissance de la parole, et pensent qu’il pourrait également être utilisé pour comprendre d’autres phénomènes cognitifs, tels que les limites de ce à quoi une personne peut prêter attention ou se souvenir, explique McDermott.